五部门关于开展2024年江南网页版登录入口官网下载 下乡活动的通知

美国特斯拉撞上白色卡车,质量问题是挥之不去的噩梦?

美国特斯拉撞上白色卡车,质量问题是挥之不去的噩梦?文|营哥最近有关特斯拉的,有2件事,第一个,前不久美国媒体曝光了特斯拉在2020年底呈交给美国加州机动车管理局(DMV)的两封电子

文|营哥

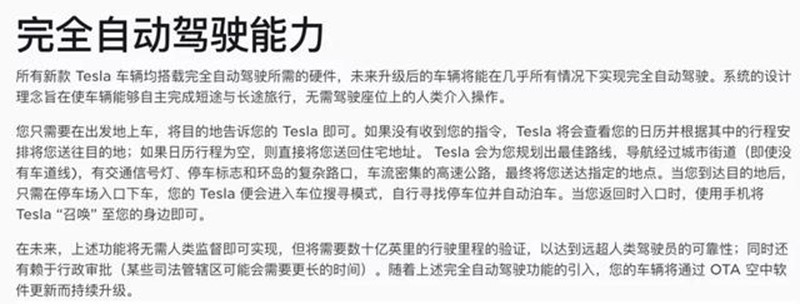

最近有关特斯拉的,有2件事,第一个,前不久美国媒体曝光了特斯拉在2020年底呈交给美国加州机动车管理局(DMV)的两封电子邮件,特斯拉在邮件中承认:FSD系统名不符实,只能和Autopilot一样具备L2级自动驾驶的功能,这一言论与马斯克口中的FSD具备L5级自动驾驶的说法相差甚远。

第2件,上周四,一辆特斯拉又双叒叕撞上了白色卡车,这已经是特斯拉第四次撞上白色卡车了(文章头图),从2016年到2021年,白色开车可以说一直是特斯拉躲不过的那个劫。

2件事无一例外的,都指向了特斯拉的自动驾驶系统目前存在的问题或者是局限性,特别是特斯拉撞白色卡车这件事,引起了国内外网友的激烈讨论。

01 特斯拉又撞上白色卡车

据外媒报道,前不久,美国底特律的一辆白色Model Y在一个路口撞上了一台白色的大卡车,Model Y车身几乎全部嵌入了货箱底下,车上的驾乘人员受伤严重。

此事一经曝出,就引发了网友的持续关注,而之所以关注度这么高,就是因为特斯拉与白色卡车的渊源实在是太深了。

2016年7月,弗罗里达州一位名叫Joshua Brown的特斯拉车主开着Model S钻到了一辆正在过马路中的白色拖挂卡车的下面,司机当场死亡。

2019年3月1日,美国弗罗里达州,一辆开启Autopilot的Model 3以110公里每小时的速度从侧向撞击了一辆正在穿过马路的白色拖挂卡车,司机也是不幸遇难。

最近的一个事故发生在我们国家的台湾,2020年6月1日,在台湾的某条高速公路上,一辆白色的货车侧翻在最里侧的道路里,后方一辆开启了Autopilot的Model 3几乎没有任何减速的就撞了上去,视频曝光以后,网友也是议论纷纷,这么明显的障碍物都识别不了吗?

而为什么被马斯克称作拥有L5级自动驾驶能力的FSD,却连续在白色大卡车这里摔了跟头,到底是视觉传感器存在弊端还是特斯拉软件的硬伤?

02 传感器的缺陷,在白色卡车面前被无限放大

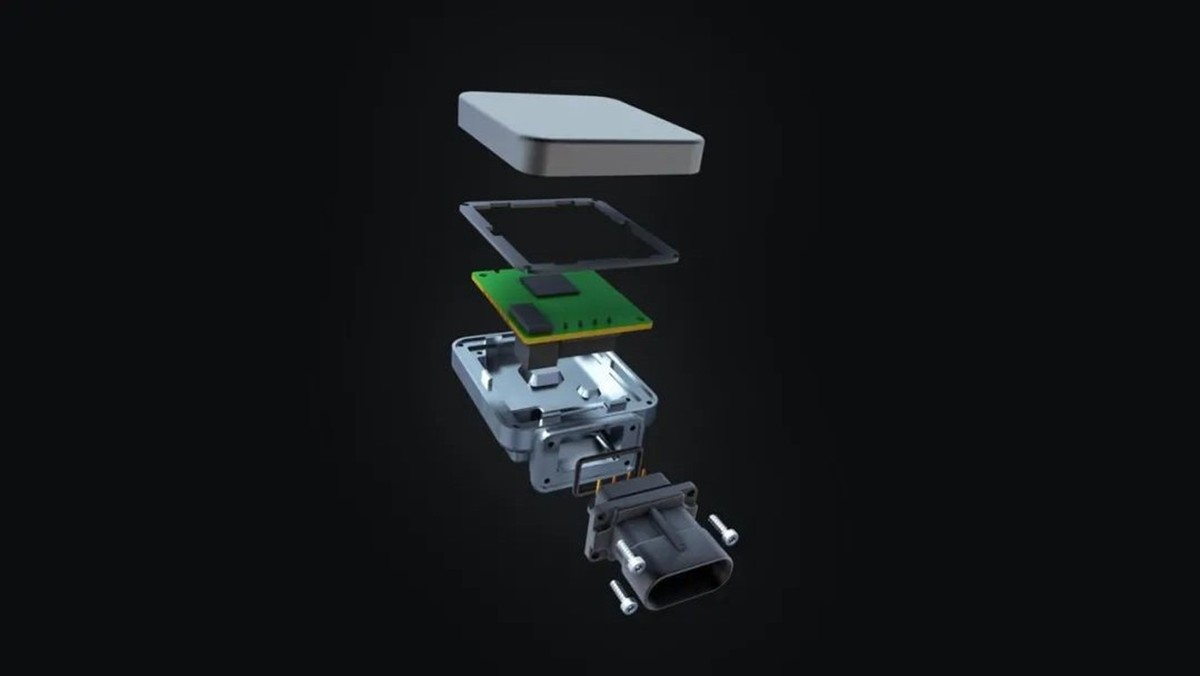

众所周知的是,特斯拉一直坚持走视觉感知路线(马斯克曾痛批激光雷达), 以目前年产能近50万台的数据来看,特斯拉不选择激光雷达的方案是理智的。

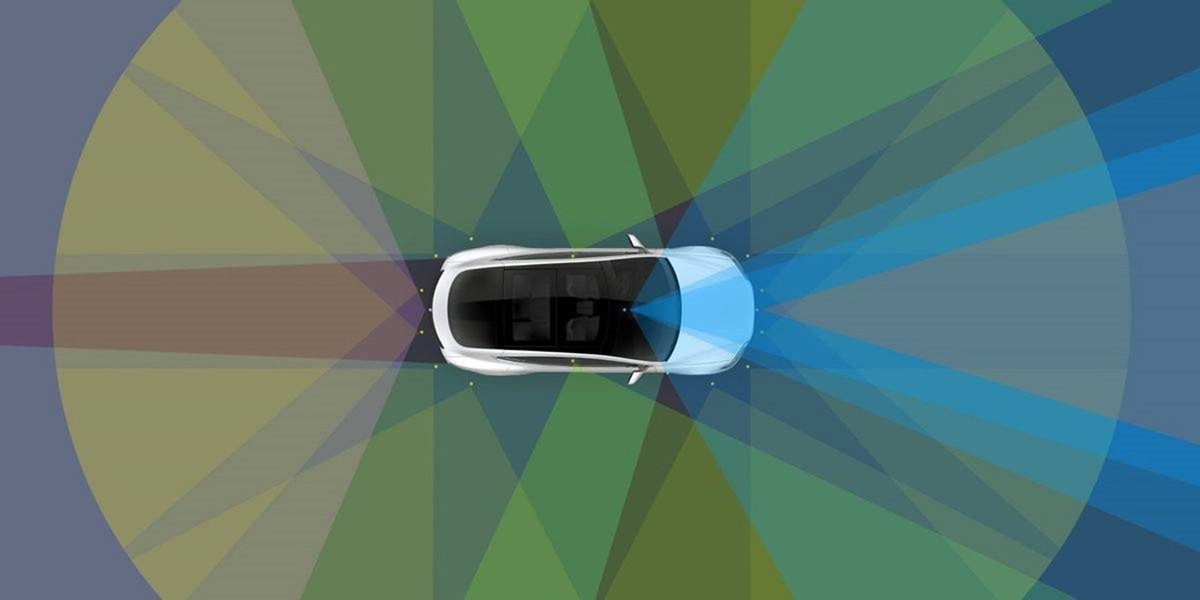

目前特斯拉车辆传感器硬件包括一个前置三目摄像头、2个前侧摄像头、2个后侧摄像头、一个后置摄像头、一个车内摄像头(未启用)、12个超声波雷达以及一个毫米波雷达。

这张图可以清晰的反映出特斯拉传感器所感知的范围,如图:

按理说这样的感知能力,一个硕大的横在马路中间的白色卡车,特斯拉应该有能力识别出来,但为何特斯拉还连续在这一个坎上摔倒了这么多次?

咱们依次分析,首先排除超声波雷达,因为它的检测距离过近,对该场景无效,我们生活中常用的倒车警报以及APS才是超声波雷达的用武之地。

其二,毫米波雷达,毫米波雷达普遍适用于长距离探测,也因此更容易识别到远处路面的白色卡车。

但卡车由于离地间隙过高,很容易出现部分毫米波直接从箱底穿过,形成漏检;此外,毫米波雷达对于静止或移动速度很慢的物体缺少敏感性,很有可能将垂直方向行驶的白色卡车过滤掉了。

其三,摄像头,特斯拉一直坚持的路线,便是纯视觉路线,但为何在这几次事故中摄像头都未能成功识别目标呢?

我的理解是特斯拉的摄像头依旧是存在很大局限,特斯拉虽然全是搭载了近8个摄像头,但收集前方道路信息的只有一个前置三目摄像头,更具体一点是三个摄像头中的广角近距摄像头,只有这个摄像头才能完整的拍下白色卡车,其他摄像头只能拍摄到卡车的局部,不能作为最终的信息来源。

但广角近距摄像头由于在相对近的距离内才可以清晰的识别出卡车,而这就导致即使系统已经识别到车辆,但也无法及时制动,最终导致撞车。

而一旦特斯拉从拖挂车下方穿过,车上人员的生存几率可以说是微乎其微,因为在这个场景中,没有任何车体溃缩和缓冲的空间与时间。

03 激进的宣传口语也需要背锅!

一直以来,特斯拉在宣传自家AutoPilot——高级辅助驾驶系统时都相当激进,很长一段时间都对外宣传的是自动驾驶。

后来事故出得太多,特斯拉甚至被德国以及韩国的的法院明令禁止使用自动驾驶这种误导消费者宣传口语,最终特斯拉才将宣传语改为自动辅助驾驶系统。

但是,特斯拉年复一年的宣传了这么久,很多消费者已经对其产生了深刻印象,现在很多消费者购买特斯拉,就是冲着它的「自动驾驶」能力去的。

这也就导致了,依旧有很多特斯拉车主在使用Autopilot时,会不由自主地放松警惕,最终增加事故发生的几率。

写在最后:

墨菲定律曾表示:如果事情有变坏的可能,不管这种可能性有多小,它总会发生,这件事放在特斯拉身上是一样的,传感器的先天的局限性使得它在特定的场景中总会出现失误,最终导致事故的发生,而在技术未能突破之间,最好的办法,只能是加强用户的教育。